python scrapy環境搭建及demo分享

前言

一個高級測試工程師在自學Python后,向我推薦的一個比較容易上手的Python 框架scrapy。在網上搜索了一下資料后感覺挺有趣的,就想著自己也搭建個環境,然后做一個爬取圖片的demo玩下。

開發環境搭建

Python安裝

下載地址:https://www.python.org/getit/

這里我下載的是3.8.0的版本(我的安裝目錄是:D:\python\Python38-32)

安裝完后設置環境變量:在path中追加:D:\python\Python38-32; D:\python\Python38-32\Scripts

升級pip

輸入命令:

python -m pip install --upgrade pip

安裝scrapy依賴的模塊

安裝wheel

進入cmd執行命令命令:

> pip install wheel

安裝pywin32

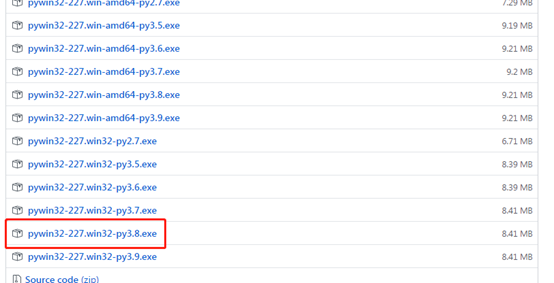

下載地址:https://github.com/mhammond/pywin32/releases

由于我安裝的Python是32位的,估選擇win32-py3.8版本,下載后雙擊安裝即可

安裝 lxml

運行命令:

> pip install lxml

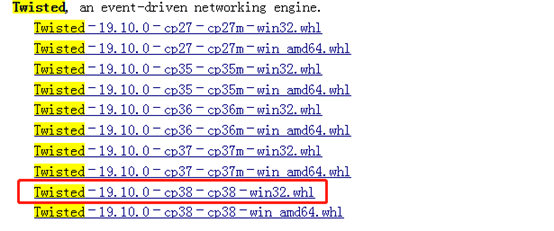

安裝Twisted

由于直接使用命令在線安裝一直報下載超時,估采用離線安裝的方式

下載地址:https://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted

運行命令:

> pip install Twisted-19.10.0-cp38-cp38-win32.whl

安裝scrapy

運行命令:

> pip install scrapy

到目前為止就完成了scrapy環境的搭建,相對簡單

編寫demo

準備內容

被爬網站

選擇百度圖片首頁:http://image.baidu.com/

規則分析

首先想到的是通過xpath的方式來爬取圖片,xpath語句://div[@class=“imgrow”]/a/img/@src。但是在編寫爬蟲(Spiders)的時候發現http://image.baidu.com/請求并沒有將圖片的URL直接返回,而是通過后面的異步請求獲取,而且返回的是一個json字符串,估xpath方式行不通。

更換異步請求的URL為被爬網站:http://image.baidu.com/search/acjson?tn=resultjson_com&catename=pcindexhot&ipn=rj&ct=201326592&is=&fp=result&queryWord=&cl=2&lm=-1&ie=utf-8&oe=utf-8&adpicid=&st=-1&z=&ic=0&word=pcindexhot&face=0&istype=2&qc=&nc=1&fr=&pn=0&rn=30

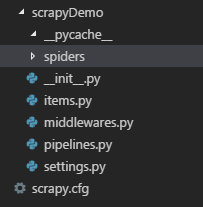

創建scrapy項目 ImagesRename

運行命令:

> scrapy startproject ImagesRename

執行完后生成項目的目錄結構如圖:

其中:

spiders目錄:用于放置爬蟲文件

items.py:用于保存所抓取的數據的容器,其存儲方式類似于 Python 的字典

pipelines.py:核心處理器,對爬取到的內容進行相應的操作,如:下載,保存等

settings.py:配置文件,修改USER_AGENT、存儲目錄等信息

scrapy.cfg:項目的配置文件

編寫item容器 items.py

import scrapy

class ImagesrenameItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

imgurl = scrapy.Field()

pass

創建蜘蛛文件ImgsRename.py

# -*- coding: utf-8 -*-

import scrapy

import json

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from ImagesRename.items import ImagesrenameItem

class ImgsRenameSpider(CrawlSpider):

name = 'ImgsRename'

allowed_domains = ['image.baidu.com']

#http://image.baidu.com/ 并沒有返回圖片鏈接,而是通過異步請求接口獲取的,爬取的URL必須是異步請求的鏈接

start_urls = ['http://image.baidu.com/search/acjson?tn=resultjson_com&catename=pcindexhot&ipn=rj&ct=201326592&is=&fp=result&queryWord=&cl=2&lm=-1&ie=utf-8&oe=utf-8&adpicid=&st=-1&z=&ic=0&word=pcindexhot&face=0&istype=2&qc=&nc=1&fr=&pn=0&rn=30',]

def parse(self, response):

# 實例化item

item = ImagesrenameItem()

#解析異步請求返回的json字符串

#經過分析需要的圖片鏈接保存在json——》data——》hoverURL

jsonString = json.loads(response.text)

data = jsonString["data"]

imgUrls = []

#循環將圖片URL保存到數組中

for d in data:

if d:

hov = d["hoverURL"]

imgUrls.append(hov)

item['imgurl'] = imgUrls

yield item

編寫核心處理器圖片下載中間件pipelines.py

# -*- coding: utf-8 -*-

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html

import re

from scrapy.pipelines.images import ImagesPipeline

from scrapy import Request

class ImagesrenamePipeline(ImagesPipeline):

def get_media_requests(self, item, info):

# 循環每一張圖片地址下載

for image_url in item['imgurl']:

#發起圖片下載的請求

yield Request(image_url)

修改配置文件settings.py

# -*- coding: utf-8 -*-

# Scrapy settings for ImagesRename project

BOT_NAME = 'ImagesRename'

SPIDER_MODULES = ['ImagesRename.spiders']

NEWSPIDER_MODULE = 'ImagesRename.spiders'

# Crawl responsibly by identifying yourself (and your website) on the user-agent

#USER_AGENT = 'ImagesRename (+http://www.yourdomain.com)'

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.131 Safari/537.36'

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

ITEM_PIPELINES = {

'ImagesRename.pipelines.ImagesrenamePipeline': 300,

}

# 設置圖片存儲目錄

IMAGES_STORE = 'E:\圖片'

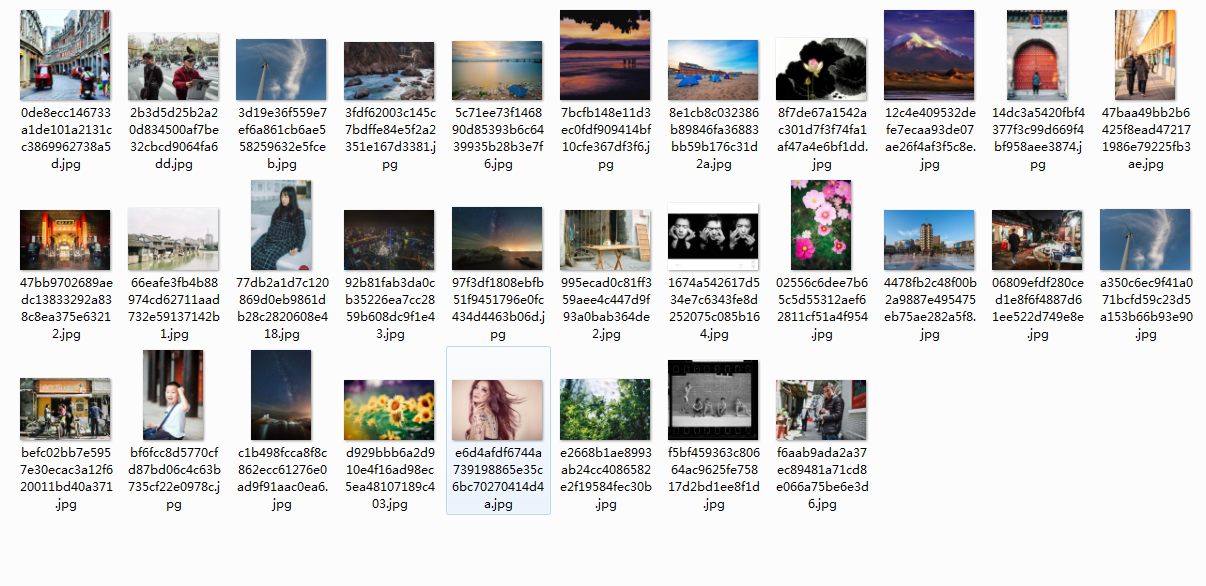

啟動程序下載圖片

運行命令:

scrapy crawl ImgsRename

到目前為止就已經完成了一個簡單的圖片爬取程序,結果如圖:

當然這些下載的文件名稱是一個隨機數,如果需要按照一個格式的文件名存儲則可以重新ImagesPipeline類的file_path方法即可,這里就不做詳細的介紹

智能推薦

win10 python安裝及環境配置、scrapy框架安裝及PyCharm集成

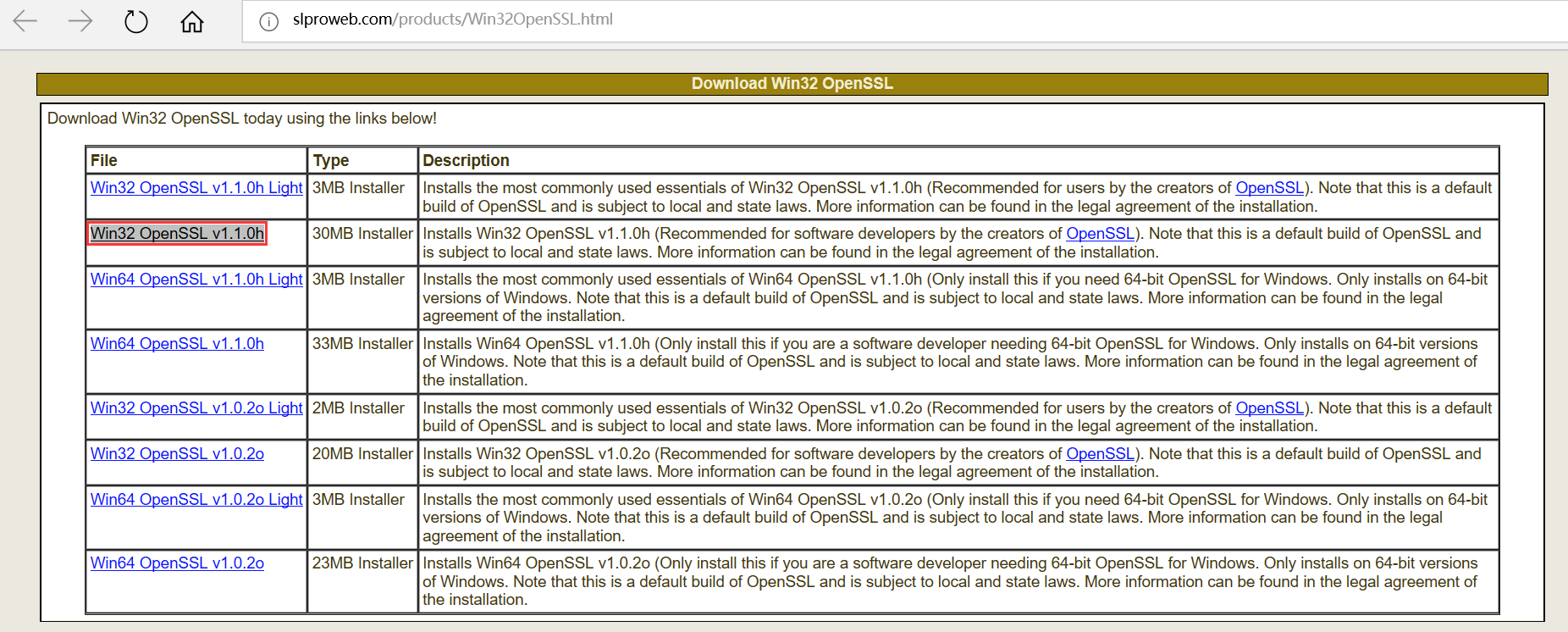

Scrapy是一個為了爬取網站數據,提取結構性數據而編寫的Python應用框架。 可以應用在包括數據挖掘,信息處理或存儲歷史數據等一系列的程序中。 Scrapy安裝環境必備項:python、pip工具、wheel模塊、lxml模塊、twisted模塊、pyOpenSSL模塊(需要OpenSSL)、scrapy模塊 1、pip是一個安裝和管理 Python 包的工具 2、wheel本質上是一個 zi...

freemarker + ItextRender 根據模板生成PDF文件

1. 制作模板 2. 獲取模板,并將所獲取的數據加載生成html文件 2. 生成PDF文件 其中由兩個地方需要注意,都是關于獲取文件路徑的問題,由于項目部署的時候是打包成jar包形式,所以在開發過程中時直接安照傳統的獲取方法沒有一點文件,但是當打包后部署,總是出錯。于是參考網上文章,先將文件讀出來到項目的臨時目錄下,然后再按正常方式加載該臨時文件; 還有一個問題至今沒有解決,就是關于生成PDF文件...

電腦空間不夠了?教你一個小秒招快速清理 Docker 占用的磁盤空間!

Docker 很占用空間,每當我們運行容器、拉取鏡像、部署應用、構建自己的鏡像時,我們的磁盤空間會被大量占用。 如果你也被這個問題所困擾,咱們就一起看一下 Docker 是如何使用磁盤空間的,以及如何回收。 docker 占用的空間可以通過下面的命令查看: TYPE 列出了docker 使用磁盤的 4 種類型: Images:所有鏡像占用的空間,包括拉取下來的鏡像,和本地構建的。 Con...

requests實現全自動PPT模板

http://www.1ppt.com/moban/ 可以免費的下載PPT模板,當然如果要人工一個個下,還是挺麻煩的,我們可以利用requests輕松下載 訪問這個主頁,我們可以看到下面的樣式 點每一個PPT模板的圖片,我們可以進入到詳細的信息頁面,翻到下面,我們可以看到對應的下載地址 點擊這個下載的按鈕,我們便可以下載對應的PPT壓縮包 那我們就開始做吧 首先,查看網頁的源代碼,我們可以看到每一...

猜你喜歡

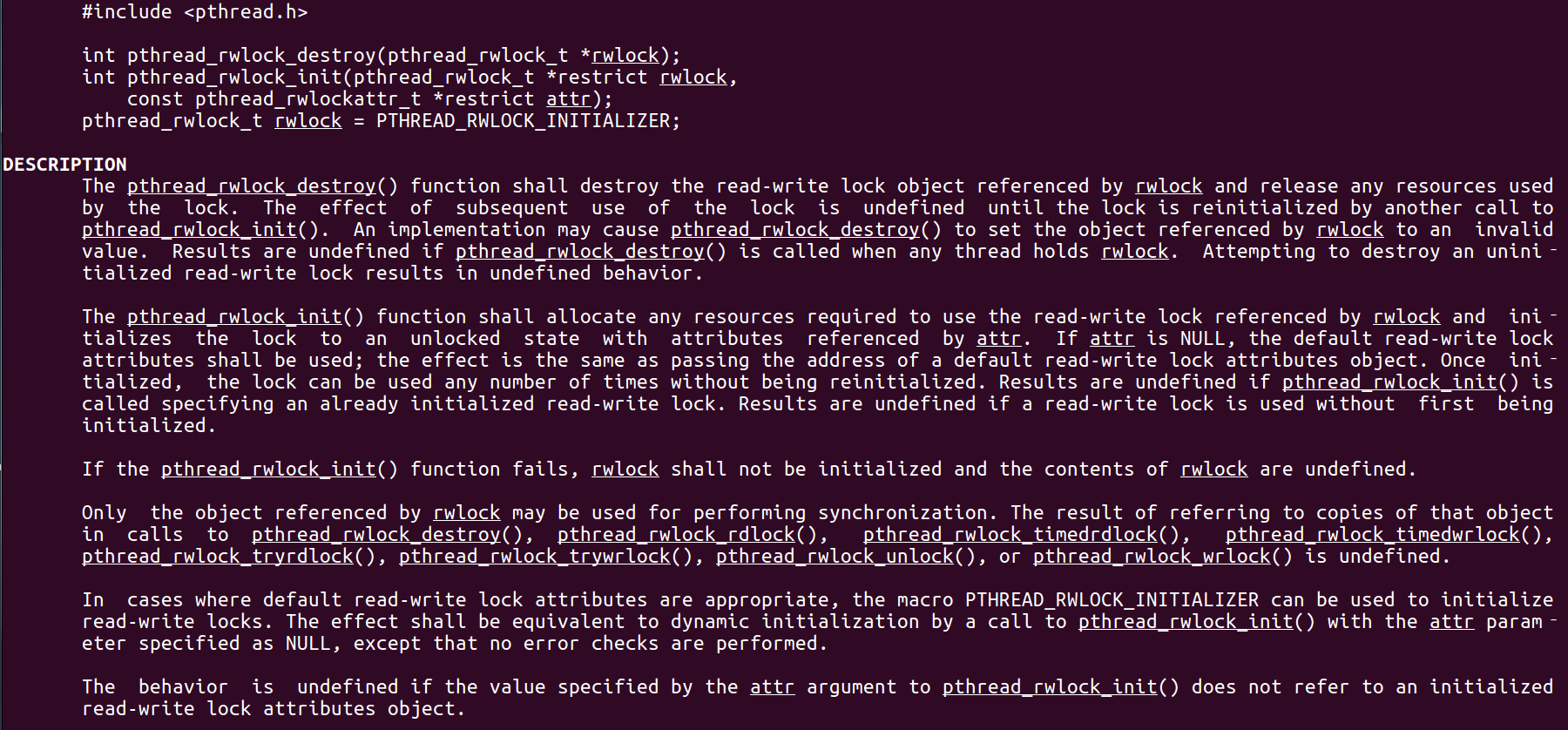

Linux C系統編程-線程互斥鎖(四)

互斥鎖 互斥鎖也是屬于線程之間處理同步互斥方式,有上鎖/解鎖兩種狀態。 互斥鎖函數接口 1)初始化互斥鎖 pthread_mutex_init() man 3 pthread_mutex_init (找不到的情況下首先 sudo apt-get install glibc-doc sudo apt-get install manpages-posix-dev) 動態初始化 int pthread_...

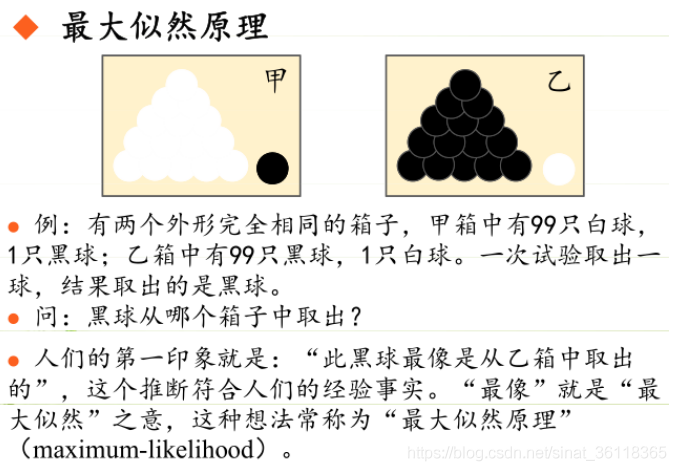

統計學習方法 - 樸素貝葉斯

引入問題:一機器在良好狀態生產合格產品幾率是 90%,在故障狀態生產合格產品幾率是 30%,機器良好的概率是 75%。若一日第一件產品是合格品,那么此日機器良好的概率是多少。 貝葉斯模型 生成模型與判別模型 判別模型,即要判斷這個東西到底是哪一類,也就是要求y,那就用給定的x去預測。 生成模型,是要生成一個模型,那就是誰根據什么生成了模型,誰就是類別y,根據的內容就是x 以上述例子,判斷一個生產出...

styled-components —— React 中的 CSS 最佳實踐

https://zhuanlan.zhihu.com/p/29344146 Styled-components 是目前 React 樣式方案中最受關注的一種,它既具備了 css-in-js 的模塊化與參數化優點,又完全使用CSS的書寫習慣,不會引起額外的學習成本。本文是 styled-components 作者之一 Max Stoiber 所寫,首先總結了前端組件化樣式中的最佳實踐原則,然后在此基...