深度學習caffe實戰筆記(4)Windows caffe平臺下跑cifar10

上一篇博客介紹了如何用alexnet跑自己的數據,能跑自己的數據按理說再跑cifar10應該沒問題了啊,但是想想還是要把cifar10的記錄下來,因為cifar10數據格式是屬于特殊的數據格式,需要用caffe環境把數據轉換文件編譯出來,這也是后面Siamese網絡所必須的一個步驟,說到Siamese網絡,,,,我要再哭5分鐘。好,五分鐘時間到,我們開始train。另外,如果是Ubuntu系統,跑cifar10只需要雙擊三個.sh文件,但是沒辦法,window系統要更加繁瑣一些,所以我覺得有必要把步驟寫下來。

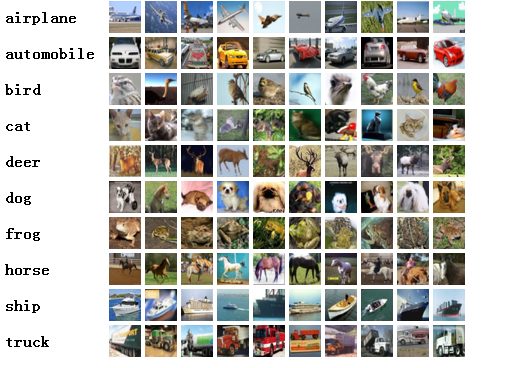

說到cifar10,我就不多做介紹了吧, Cifar-10是由Hinton的兩個大弟子Alex Krizhevsky、Ilya Sutskever收集的一個用于普適物體識別的數據集。Cifar-10由60000張32*32的RGB彩色圖片構成,共10個分類。50000張訓練,10000張測試(交叉驗證)。這個數據集最大的特點在于將識別遷移到了普適物體,而且應用于多分類(姊妹數據集Cifar-100達到100類,ILSVRC比賽則是1000類)。

在2004年,兩個大弟子拿到少量資金構建cifar10用于普適物體識別,估計當時也是看他們沒錢,施舍給他們的,呵呵,說笑了,深度學習的鼻祖,怎么能有這么灰暗的歷史呢,不過估計當時他們自己也沒有預想到后面這個數據集會有這么大的用途。

1、下載數據

從cifar10官網上下載吧。地址:http://www.cs.toronto.edu/~kriz/cifar.html,下載好了解壓縮,如下,五個訓練文件,一個測試文件

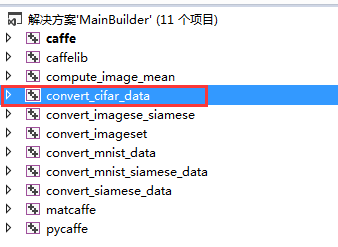

2、編譯convert_cifar_data

啊啊啊,我的caffe中沒有convert_cifar_data怎么辦?沒錯,我的電腦上的確沒有,在這個地方博主跳了好多坑,在caffe-windows-master\examples\cifar10文件夾下有一個convert_cifar_data.cpp文件,雖然有這個文件,怎么編譯啊?在caffe中新建一個工程,把cpp文件導進去,開始編譯?別做夢了,各種配置錯誤,找不到各種文件。。。。。

哈哈,不繞彎子了,博主想到了一個非常巧妙的方法,在caffe-windows-master\build_cpu_only文件夾中,有一個convert_imageset文件夾,這個是用來轉換數據的工程,在前面兩個博客中都用到了這個工程編譯的文件,把這個文件復制一下,然后把其中的release文件刪除,只保留剩下的三個文件,然后把復制的這個文件夾和文件夾里的三個文件重命名為convert_cifar_data,沒錯,就是這么巧妙!成功的解決了配置文件路徑的問題!

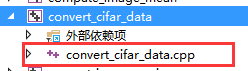

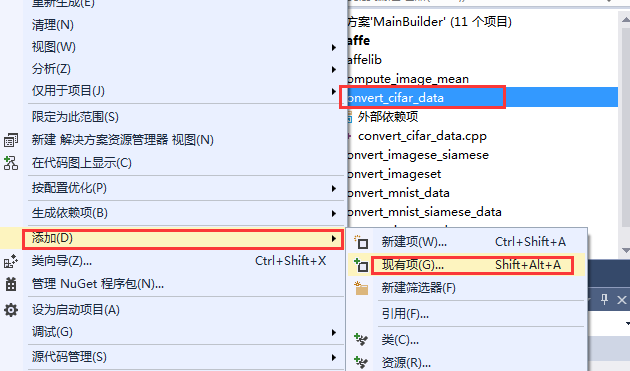

然后用vs打開復制的這個工程,這個時候這個工程的名稱還沒有換,需要重命名一下,然后把這個工程里原來的那個cpp文件移除,把在caffe-windows-master\examples\cifar10\convert_cifar_data.cpp右鍵添加進來。

添加之后:

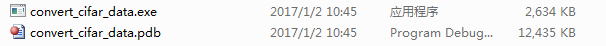

愉快的開始生成吧。生成之后,會在bin目錄下生成如下幾個文件:

其中,convert_cifar_data.exe就是我們需要的可執行文件。

3、轉換數據

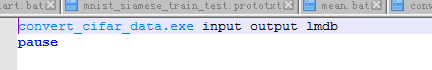

在data文件夾下新建一個cifar10train文件夾,為什么不建一個cifar10文件夾呢?因為本來已經存在一個cifar10文件了啊,哈哈哈。新建一個轉化數據的腳本文件,內容如下:

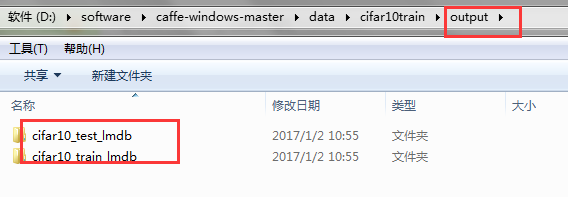

注意:input就是存放cifar10數據的文件夾,output是轉換后輸出的文件夾,lmdb是需要轉換的數據格式。雙擊運行之后,在output文件夾下會有如下:

這就是生成的訓練和測試數據。

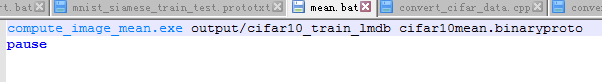

4、計算均值

這一步不啰嗦了,腳本文件如下:

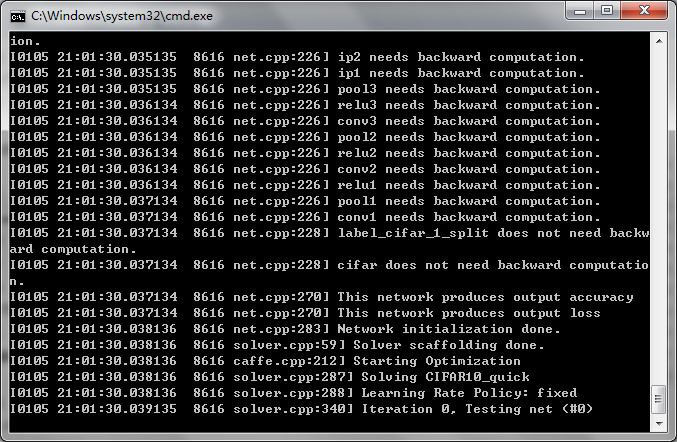

5、開始訓練

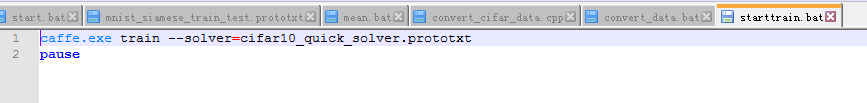

編寫開始訓練的批處理文件:

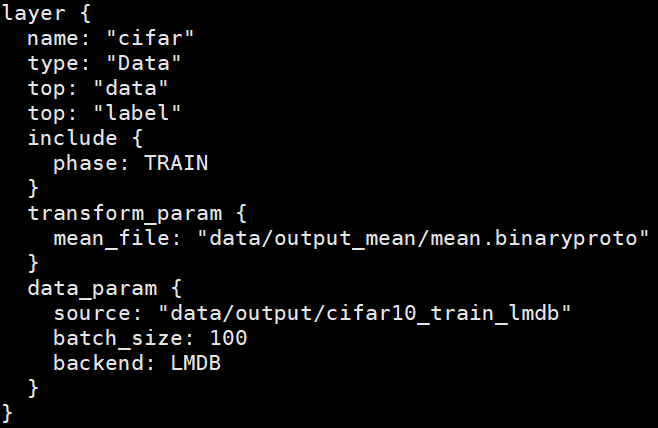

其中需要的cifar10_quick_solver.prototxt和cifar10_quick_train_test.prototxt在caffe-windows-master\examples\cifar10文件夾下都有,這兩個協議文件中如何修改,不用多說了吧,如果忘了,去看我上一篇博客,說的很清楚了,不說了。

我記得最后的精度好像是73%.。。。。。。

其實訓練cifar10整體流程和之前的是一樣的,只不過是數據轉換時是不一樣的,這應該是在windows環境下,訓練cifar最詳細的一個說明了吧。

<link rel="stylesheet" href="https://csdnimg.cn/release/phoenix/production/markdown_views-68a8aad09e.css">

</div>

智能推薦

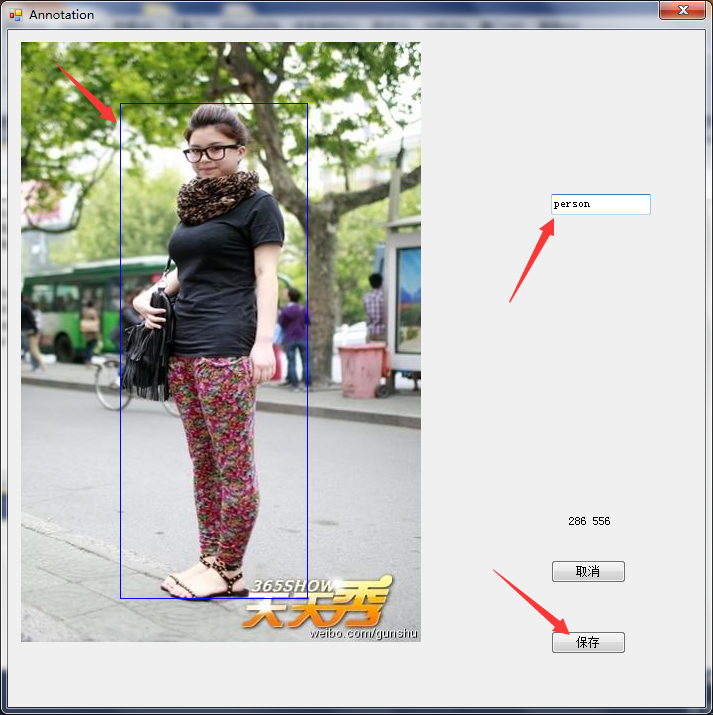

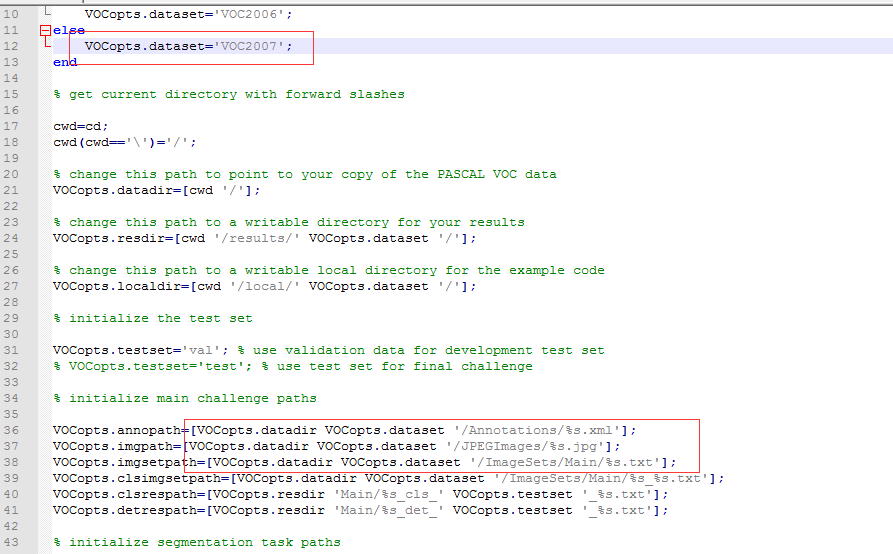

深度學習Caffe實戰筆記(19)Windows平臺 Faster-RCNN 制作自己的數據集

萬里長征第一步,就是要制作自己的數據集,過程還是比較繁瑣的,特別是標注的過程,這篇博客先介紹如果制作voc2007自己的數據集用于faster-rcnn訓練,下一篇博客介紹如何用faster-rcnn訓練自己的數據。 1、準備圖像 圖像要用.jpg或者jpeg格式的,如果是png或者其它格式,自己轉換一下就好,圖像名稱要用000001.jpg,只有和VOC2007數據集圖像名稱一致,才能最大限度的...

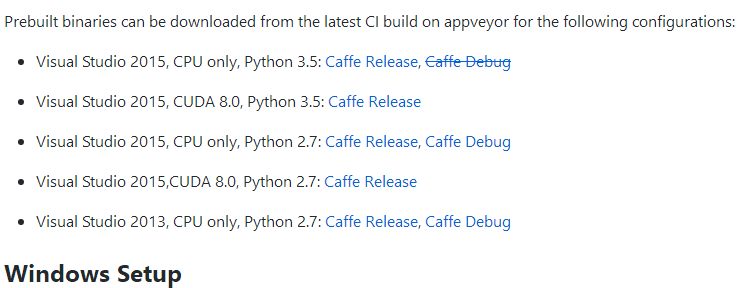

深度學習Caffe實戰筆記(18)Windows平臺 Faster-RCNN 環境配置

好久不寫博客了,因為前一段時間博主身體抱恙,感觸頗多。。。。。。都說windows平臺做caffe和tensorflow坑多,博主沒有太多優點,唯獨的一個優點就是不服輸,Windows平臺雖然坑多,但是填坑也是蠻有意思的一件事情。另外,在Siamese網絡訓練自己的數據那個博客,經過高人點評,有些不太完善的地方,具體的信息請看那篇博客的一個長評論。 勞動節的時候幫一個師妹配置caffe,她說要做R...

深度學習Caffe實戰筆記(20)Windows平臺 Faster-RCNN 訓練自己的數據集

昨天晚上博主干到12點多,終于用了一晚上時間搞定了Faster-Rcnn訓練自己的數據集,這篇博客介紹如何用faster_rcnn訓練自己的數據集,前提是已經準備好了自己的數據和配置好了faster-rcnn的環境。 制作數據集教程:http://blog.csdn.net/gybheroin/article/details/72581318 環境配置教程:http://blog.csdn.net...

caffe-windows 配置和cifar10數據集訓練

之前的文章中已經使得OpenCV能利用訓練好的分類器進行圖像的分類了,但最為關鍵的一步還沒做,那便是分類器的獲得。畢竟我們不可能用別人訓練好的分類器很好的解決自己工程上的問題。 本篇,將開始對分類器的探索! 本人選用的是開源世界現在最流行的深度學習架構,至于為何怎么選,因為看到別人都這么選。。至于別的會不會更好,以后再說吧,有更深入的研究會跟大家分享。 第一步是下載,這個沒什么說的...

caffe入門學習(3):Exmaple cifar10訓練和測試步驟

可以先看下官網說明文檔 http://caffe.berkeleyvision.org/gathered/examples/cifar10.html cifar10是什么? CIFAR-10 是一個包含60000張圖片的數據集。 其中每張照片為32*32的彩色照片,每個像素點包括RGB三個數值,數值范圍 0 ~ 255。 所有照片分屬10個不同的類別,分別是 ‘airplane&rsq...

猜你喜歡

caffe學習:CIFAR-10

點擊打開鏈接 使用數據庫:CIFAR-10 60000張 32X32 彩色圖像 10類,50000張訓練,10000張測試 具體操作實現: (1)獲取數據庫 [python] view plain copy #下面假定caffe的根目錄是 CAFFE_ROOT,在終端輸入命令下載數據集: cd $CAFFE_ROOT&nb...

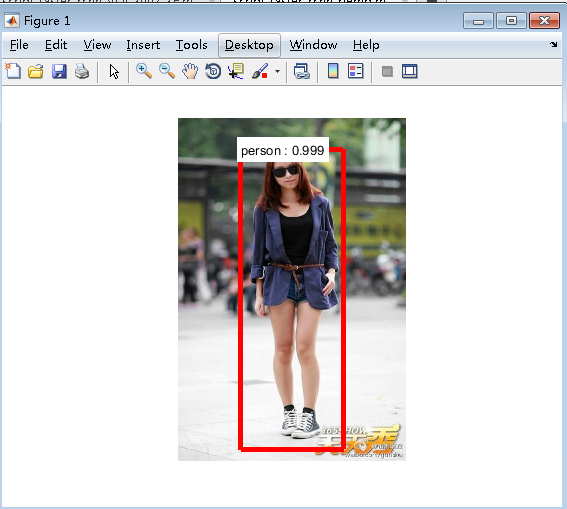

深度學習Caffe實戰筆記(21)Windows平臺 Faster-RCNN 訓練好的模型測試數據

前一篇博客介紹了如何利用Faster-RCNN訓練自己的數據集,訓練好會得到一個模型,這篇博客介紹如何利用訓練好的模型進行測試數據。 1、訓練好的模型存放位置 訓練好的模型存放在faster_rcnn-master\output\faster_rcnn_final\faster_rcnn_VOC2007_ZF,把script_faster_rcnn_demo.m文件拷貝到faster_rcnn-m...

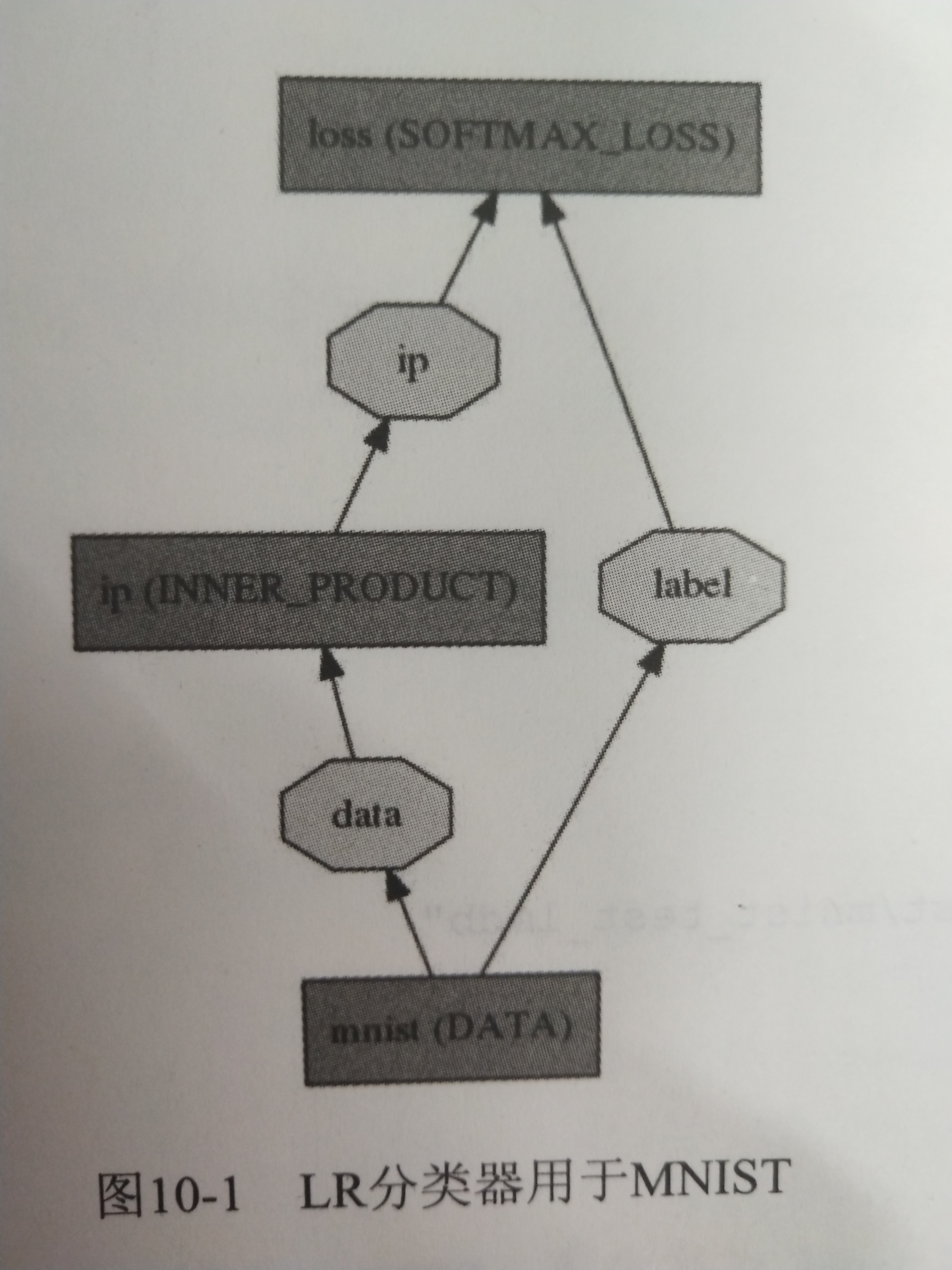

《深度學習——實戰caffe》——caffe模型

一個完整的深度學習系統最核心的兩個方面是數據和模型。 深度學習模型通常由三部分參數組成: 可學習參數(Learnable Parameter),又稱可訓練參數、神經網絡權系數、權重,其數值由模型初始化參數、誤差反向傳播過程控制,一般不可人工干預。 結構參數(Archetecture Parameter),包括卷積層、全連接層、下采樣層數目、卷積核數目、卷積核大小等描述網絡結構參數,一旦設定好,...

天河二號運行CAFFE CIFAR10例程

天河二號自備有caffe1.0.0的程序庫,所以不需要自行編譯(如果有特殊需要也可以自行編譯) 運行caffe例程有以下幾個步驟: 加載caffe: 這一步系統會自動加載對應的環境變量進入系統中 調用which caffe可以查看caffe程序的具體位置。 2. 上傳對應的數據和proto文件到相應的文件夾中。 CIFAR10數據需要自己下載,下載地址: http://www.cs.toronto...